loading...

Влияние пропаганды на общественное мнение, реакция администрации соцсети на жалобы, а также юридические аспекты, связанные с распространением иностранной пропаганды на американской платформе — МОСТ.Медиа изучил все стороны этой проблемы

11 Августа 2025 г.

С февраля 2022 года российская пропаганда развернула масштабную информационную кампанию для оправдания агрессии и подрыва поддержки Украины на международной арене. Ключевым нарративом стала риторика о «денацификации» Украины – утверждения о том, что страной правят нацисты, и Россия вынуждена очистить соседнее государство от экстремистов. Эта линия сопровождалась разжиганием ненависти и дегуманизацией украинцев, включая этнические оскорбления, с целью оправдать насилие. Одновременно Кремль продвигал тезисы о том, что Украина – марионетка Запада, а расширение НАТО и «агрессия» США/ЕС вынудили Россию начать «специальную операцию». В информационном пространстве появлялись и конспирологические теории – например, о тайных биолабораториях США в Украине или постановочных массированных убийствах (в частности, отрицание резни в Буче, выдаваемой за инсценировку).

В то время как внимание многих журналистов-расследователей сместилось на исследование активности пророссийских групп в сети X (Twitter) и Telegram, российские пропагандисты развивали свои методы продвижения на других социальных платформах. И прежде всего в Facebook.

Наше расследование показало: скоординированная сеть фейковых аккаунтов и страниц в Facebook искусственно увеличивала вовлечённость публикаций — лайками, комментариями и репостами. Это позволяло пропаганде обходить алгоритмы платформы и усиливать влияние на западную аудиторию, включая американских избирателей.

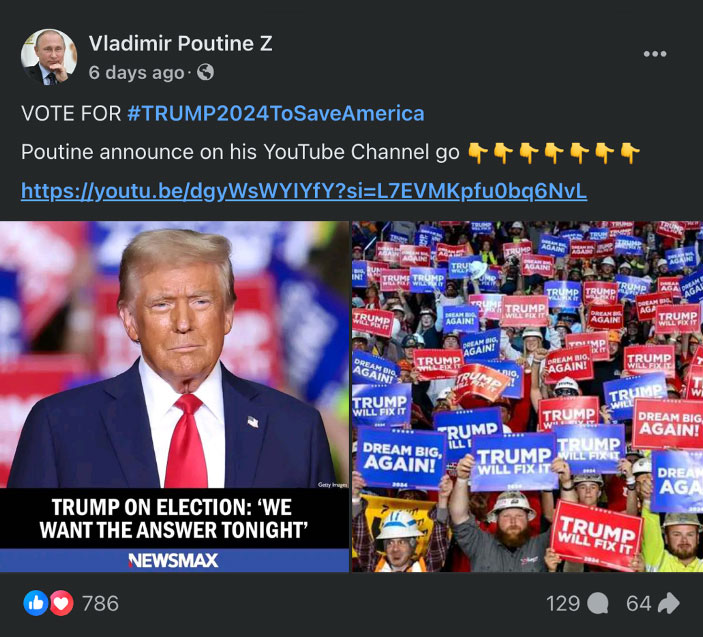

Особо изощренной формой продвижения пророссийской пропаганды в Facebook стали публикации и даже целые страницы, посвященные демонстрации систем российского вооружения и их “техническое превосходства”, а также визуальный контент с изображениями культурных и исторических объектов, куда добавлялись AI-генерированные элементы. Такие публикации создают эффект “мягкой силы” (Joseph Nye, Soft Power: The Means to Success in World Politics), нацеленной на формирование положительного восприятия России за рубежом. Визуально привлекательные сцены могли сопровождаться пропагандистскими подписями или символикой, укрепляя основные нарративы кампании и способствуя их распространению среди разных категорий западной аудитории. А некоторые из выявленных публикаций были намеренно адаптированы под политический контекст США, что могло косвенно или прямо повлиять на предпочтения американских избирателей, особенно в преддверии выборов.

Подобные публикации не только подрывают поддержку Украины и усиливают антинатовские настроения, но и могли повлиять на последние президентские выборы в США, формируя общественное мнение по ключевым вопросам международной политики.

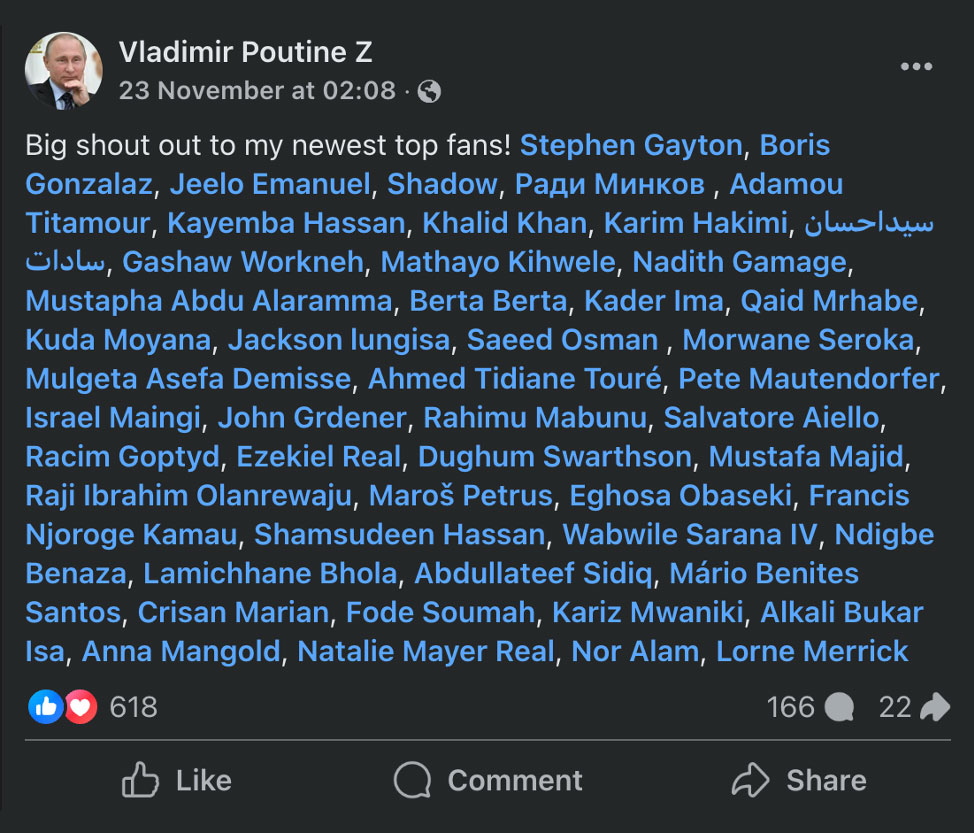

Пример публикации с профиля Vladimir Poutine Z: скрытая манипуляция общественным мнением через поддержку Трампа. Такие посты выглядят как внутренняя политическая агитация, но за счет использования псевдопрофилей, подобных этому, становятся частью масштабной иностранной информационной кампании.

Призывы прекратить военную поддержку Украине в 2023-2024 гг. стали точкой пересечения риторики Кремля и предвыборных заявлений Трампа. По оценкам экспертки по политическим коммуникациям, профессора Сары Отс, выборы 2024 года в США стали одними из самых значимых для России, поскольку в случае победы Трампа существенное сокращение американской помощи Украине было весьма вероятно. Российская пропаганда всячески подогревала настроения в пользу такого исхода. В информационном поле Facebook это выразилось в появлении контента, рассчитанного на американских консерваторов и сторонников Трампа.

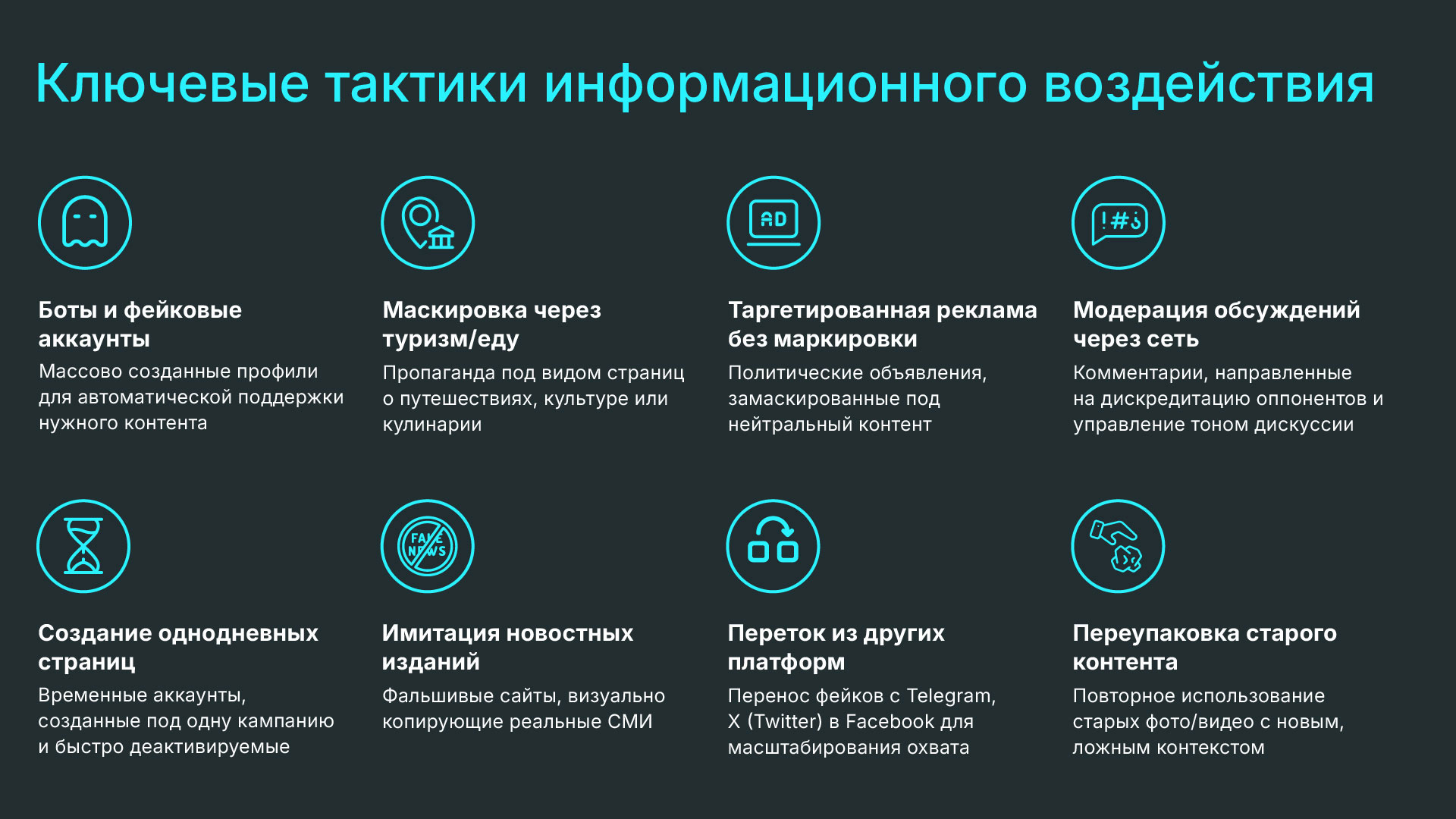

Для продвижения своего контента в Facebook пророссийские акторы использовали целый арсенал тактик, часто опираясь на уязвимости алгоритмических механизмов платформы. В отчетах Meta такие скоординированные операции обозначаются как CIB (Coordinated Inauthentic Behavior) – координированная неаутентичная активность. Вот ключевые методики, выявленные в период после 2022 года.

Как и в предыдущие годы, база операций составляли тысячи подставных профилей, выдававших себя за обычных пользователей или администраторов страниц со схожими интересами. Ранее Meta неоднократно раскрывала и блокировала подобные сети. Например, в 2022 году была разоблачена крупнейшая с начала войны сеть, связанная с Россией: более 1600 фейковых аккаунтов и страниц, координировано распространявших кремлевскую пропаганду о войне. Эта кампания, начавшаяся в мае 2022, включала более 60 поддельных новостных сайтов, имитировавших известные издания (Spiegel, The Guardian, Bild и др.) на разных языках. После публикации материалов с прокремлевской повесткой (очернение Украины, дискредитация беженцев, утверждения о том, что санкции не работают и вредят только странам, которые их вводят) организаторы массово делились ссылками на эти сайты через сеть фиктивных аккаунтов в Facebook, Instagram, Twitter, Telegram, а также запускали по ним рекламу.

Meta охарактеризовала эту операцию как сочетание технически сложных элементов (имитация сайтов СМИ на семи языках потребовала значительных ресурсов) и грубой силы (множество фальшивых профилей и рекламу). Такой “гибридный” подход позволял злоумышленникам сравнительно быстро охватить широкую аудиторию: они не тратили время на органический рост подписчиков, а сразу нагнетали информационное пространство массированной рассылкой однотипных сообщений. Подобные атаки «в лоб» на информационную среду скорее рассчитаны на краткосрочный эффект («hit-and-run»), чем на долгосрочное создание доверия, но могут наносить значимый урон до момента их нейтрализации.

1 600

фейковых аккаунтов и страниц, координировано распространявших кремлевскую пропаганду о войне

Алгоритмы соцсети, предназначенные для таргетинга рекламы, стали оружием в руках пропагандистов. Выяснилось, что пророссийские группы активно закупали рекламные объявления с политическим содержанием, обходя при этом контроль. В ходе расследования AI Forensics были обнаружены тысячи рекламных объявлений от анонимных страниц, продвигавших прокремлевские месседжи в странах ЕС. Причем более 65% такой политической рекламы выходило без требуемой маркировки (то есть Facebook не пометил ее как политическую) и не сопровождалось информацией об оплачивающей стороне. Это свидетельствует об уязвимости алгоритмов модерации рекламы: злоумышленники научились создавать однодневные страницы, которые публиковали оплаченный пост, мгновенно охватывали десятки или сотни тысяч пользователей, а затем удалялись. «Страница фактически создается лишь ради оплаты объявления, чтобы сразу достичь широкой аудитории, а затем просто удаляется – это эффективнее, чем долго растить сообщество в надежде на охват» – отмечает исследователь Пол Бушо из AI Forensics.

Кроме того, таргетированная реклама использовалась не только для вброса идей, но и как инструмент аналитики: российские операторы наблюдали, какие сообщения заходят лучше, отслеживая реакции пользователей в режиме реального времени. В одном из документов, созданных прокремлевским политтехнологом Ильей Гамбашидзе в рамках дезинформационной кампании Good Old Usa Project, прямо говорится: «Таргетирование в Facebook позволяет отслеживать реакцию аудитории на распространяемые материалы и корректировать дальнейшие запуски, исходя из того, какая группа была затронута сильнее всего».

Таким образом, рекламная платформа Facebook служила своего рода полигоном для тестирования пропаганды, где посредством A/B-тестов враги подбирали наиболее действенные нарративы. Во второй половине 2022 года специалиста Meta сумели вручную идентифицировать и нейтрализовать вредоносные аккаунты, которые еще не были удалены автоматическими системами до начала полноценного расследования.

>65%

политической рекламы, распространялось без маркировки на Facebook

Алгоритмы ленты Facebook устроены так, чтобы показывать пользователю наиболее релевантный и интересный для него контент – зачастую то, что вызывает сильную эмоциональную реакцию (гнев, возмущение, страх). Пропагандисты умело этим пользуются, распространяя максимально провокационные посты и изображения, провоцирующие споры. Чем активнее люди комментируют или делятся записью (пусть даже возмущаясь), тем шире алгоритм разносит ее по сети. В случае пророссийской дезинформации это означает, что крайне поляризующий контент получает непропорционально высокий охват. Исследования показывают, что платформы, оптимизированные под вовлеченность, невольно способствуют быстрому вирусному распространению лжи и теорий заговора.

Кроме того, злоумышленники практиковали тактику искусственного разгона вовлеченности: создавались группы «ботов» или подконтрольных аккаунтов, которые сразу после публикации начинали массово лайкать и комментировать нужный пост, чтобы “раскрутить” его в алгоритмическом рейтинге. В уже упомянутом плане “Good Old USA” говорилось о применении «сети ботов», которые будут модерировать топ-дискуссии в комментариях и направлять их русло в выгодную сторону. Имеется в виду, что под каждой целевой публикацией появляется десятки скоординированных комментариев, создающих видимость массовой поддержки данной позиции либо травли противоположной. Рядовые пользователи, увидев такой “резонанс”, могут ошибочно принять пропагандистский вброс за широко разделяемое мнение.

Российские операторы заранее создавали и вели, порой в течение месяцев, сообщества в Facebook, маскируясь под локальные группы по интересам – например, группы сторонников Трампа в отдельных штатах («Alabama for America the Great» и т.п.). Такие группы наполнялись нейтральным или околосозвучным контентом, не вызывая подозрений. План состоял в том, что к решающему моменту эти «спящие ячейки» в соцсети будут пробуждены: администраторы резко переключатся на распространение агитматериалов, превращая группы с уже набранной аудиторией в инструмент воздействия на общественное мнение. В судебных документах по делу Гамбашидзе, рассекреченных Минюстом США, фигурировали намерения создать по 18 таких ячеек в ключевых колеблющихся штатах США, чтобы в решающий момент они начали слаженно продвигать нужные нарративы и ссылки.

Подобная тактика опирается на встроенные механизмы рекомендаций Facebook: люди в таких группах начинают делиться материалами, которые могут дальше расходиться по их лентам друзей, а алгоритмы могут рекомендовать вступить в популярные группы знакомым с похожими интересами, что увеличивает охват.

по 18

«спящих ячеек» планироапли создать в каждом ключевом колеблющемся штате США

Хотя вопрос фокусируется на Facebook, стоит упомянуть, что многие операции были кроссплатформенными. Контент и фейки, появившиеся на других ресурсах (например, сгенерированные фальшивые видео на YouTube или “сливы” в Telegram), часто затем попадали в Facebook через пользователей, которые делились ссылками. Таким образом, пропагандисты использовали экосистему соцмедиа в комплексе: если одна площадка блокировала их аккаунты, они все равно добивались охвата на другой и возвращались через нее. Facebook в данном случае нередко становился вторичным ретранслятором дезинформации, запущенной за его пределами, особенно когда ею делились реальные люди, введенные в заблуждение. Например, описанные выше фейковые видео с «украинскими солдатами против Трампа» изначально распространялись на пророссийских каналах, но затем их подхватили американские конспирологические группы в Facebook, благодаря чему охват значительно вырос.

Таким образом, российская пропагандистская сеть в Facebook представляет собой сложную структуру, состоящую из сотен фейковых аккаунтов и страниц, действующих слаженно для распространения пророссийских нарративов. Эти аккаунты, многие из которых искусственно взаимодействуют друг с другом, создают иллюзию широкой поддержки России и ее политики, особенно на фоне текущего конфликта с Украиной. Они активно комментируют и репостят публикации друг друга, что повышает индекс вовлеченности и усиливает охват контента.

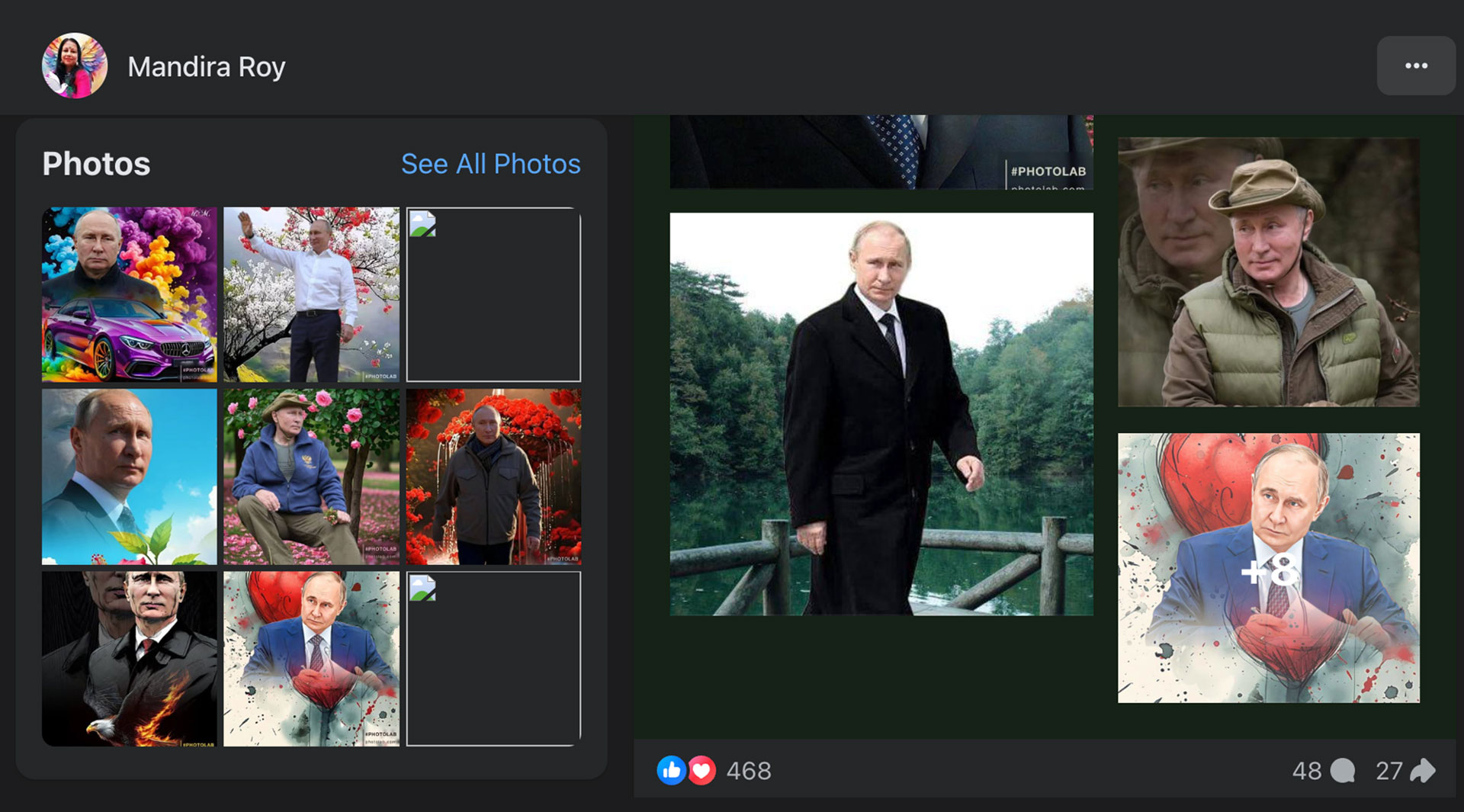

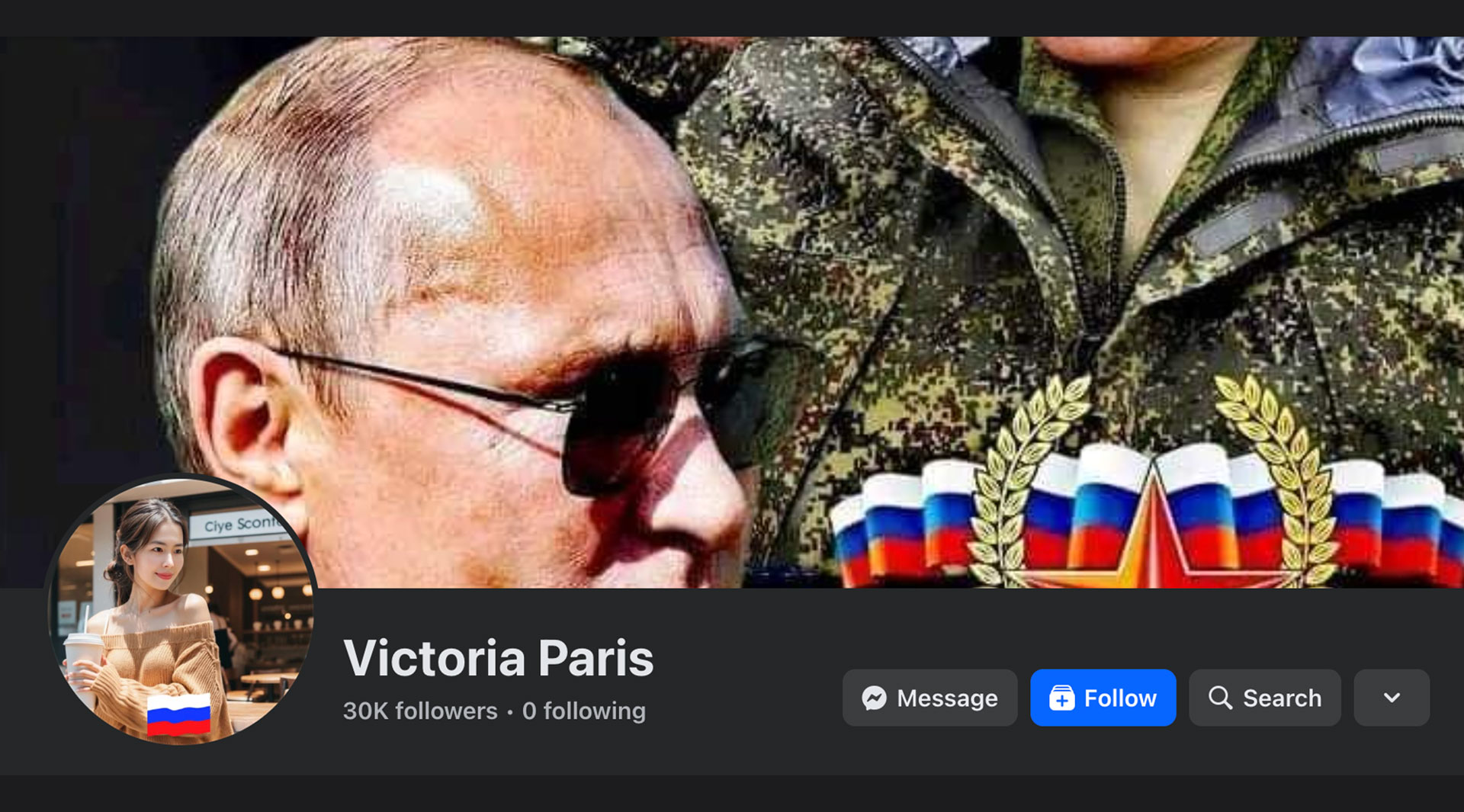

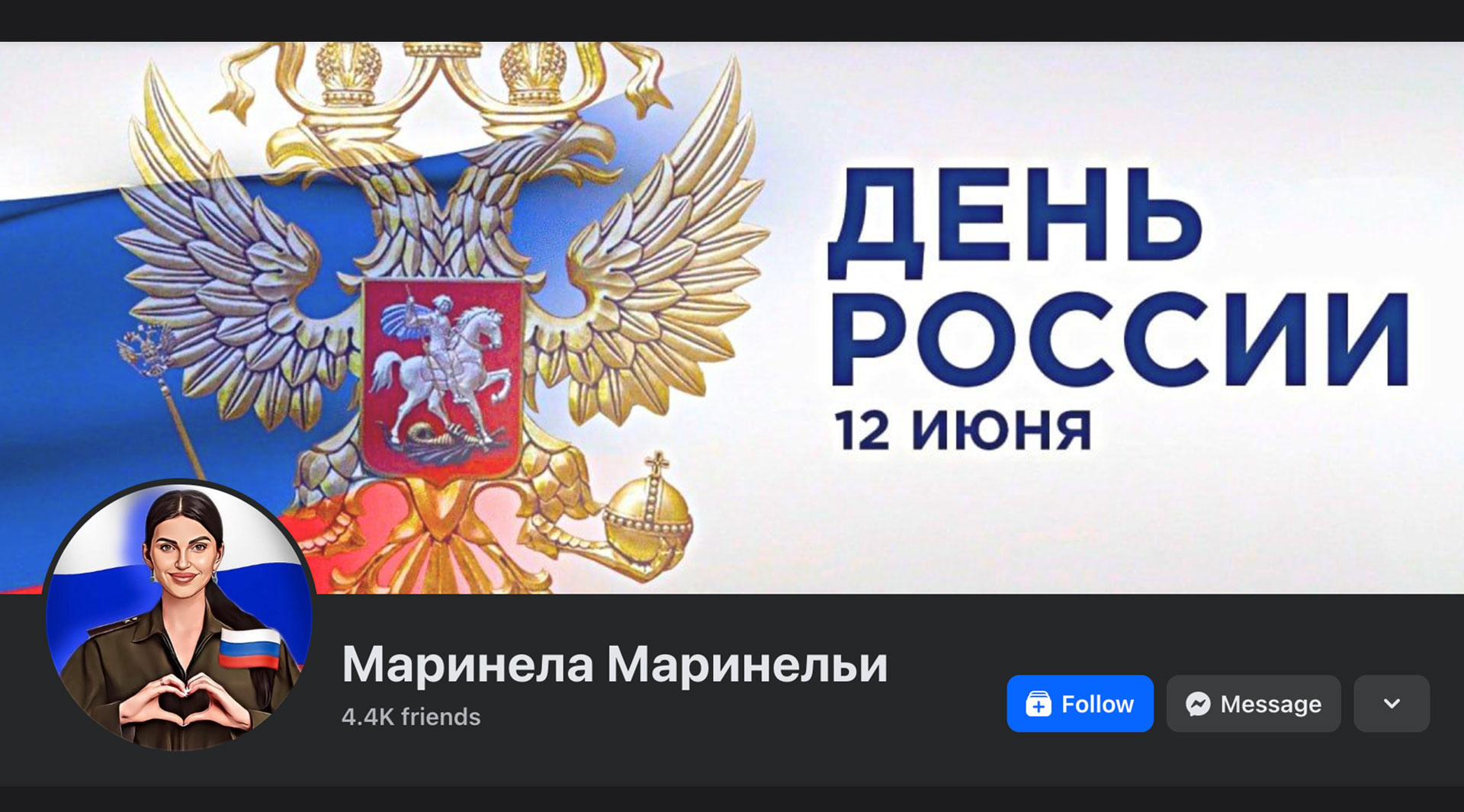

Многие из этих страниц имеют тысячи подписчиков и регулярно публикуют изображения и видео, демонстрирующие российскую военную технику и символику, включая символ «Z», связанный с российскими вооруженными силами. Примеры таких страниц, как «Vladimir Poutine Z», показывают, как визуальные материалы и национальная символика используются для усиления пророссийских настроений.

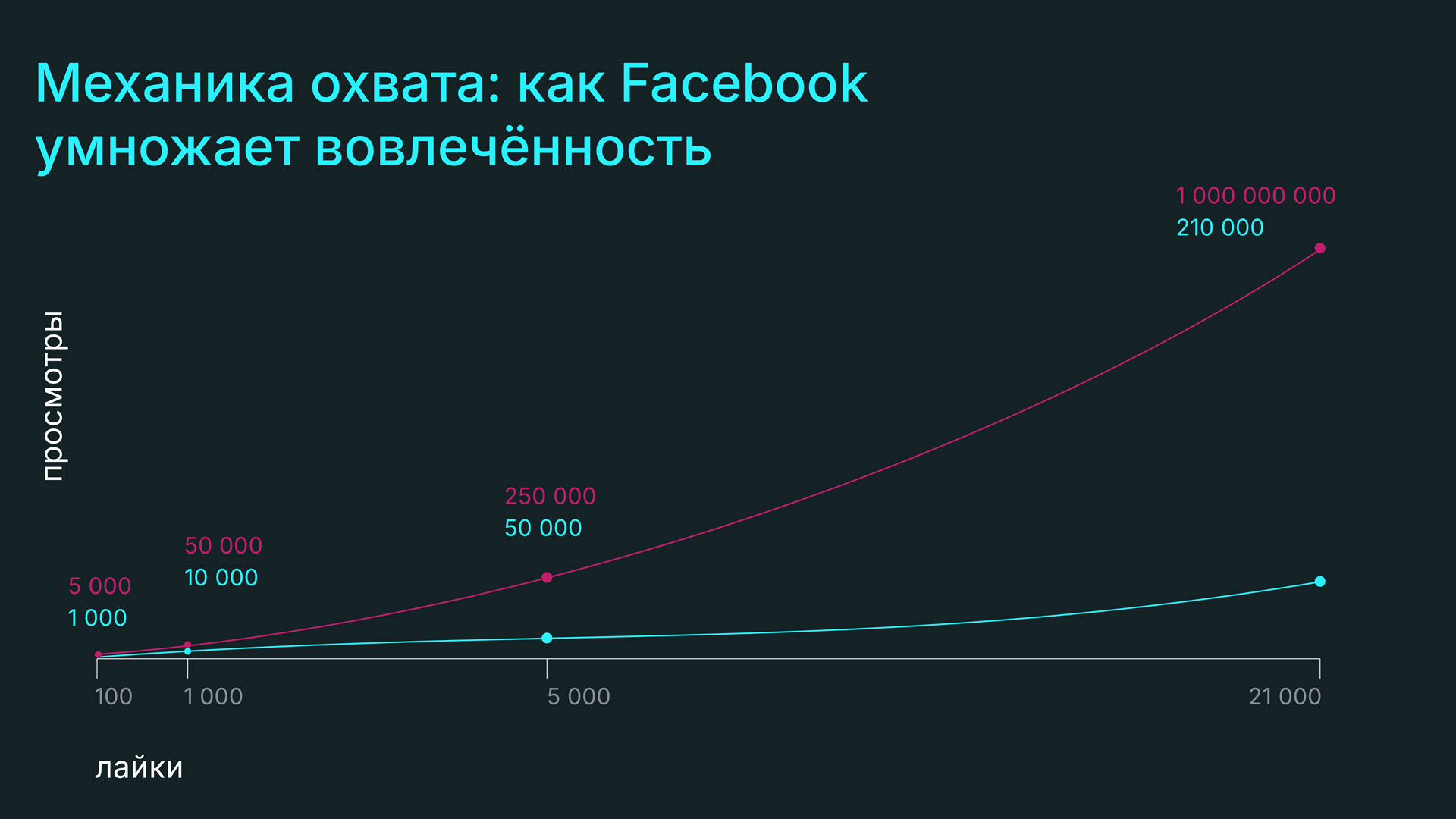

Для оценки охвата пророссийских публикаций в Facebook мы применили подход, основанный на анализе активности (лайки, комментарии, репосты) и существующих исследований [ by Daniel Schneider , Director, Content Marketing – “ Как эффективно рассчитать коэффициент вовлеченности?” ], по коэффициентам вовлеченности. Согласно ряду аналитических данных, средний коэффициент лайков к просмотрам на Facebook согласуется с диапазоном от 2% до 10%. Это позволяет оценить просмотры на основе числа лайков: 1 лайк может соответствовать примерно 10–50 просмотрам в зависимости от уровня вовлеченности аудитории и типа контента.

Например, публикация с 5 тысячами лайков могла бы охватить от 50 до 250 тысяч просмотров. Уровень вовлеченности, выраженный в комментариях и репостах, также играет значимую роль, повышая охват публикаций.

При этом важным фактором является не происхождение лайков и комментариев, а их влияние на алгоритмы Facebook. Высокая активность под постами, организуемая в том числе с помощью фейковых аккаунтов или с использованием так называемой "фабрики троллей", приводит к тому, что контент продвигается органически и виден в лентах пользователей, не подписанных на эти страницы. Это позволяет пророссийскому контенту охватывать более широкую аудиторию, обходя ограничения на рекламу и дезинформацию. План Good Old USA, разработанный в рамках российских информационных операций, предусматривал создание и использование «сети ботов» для создания и модерирования топ-дискуссий в комментариях. Эти боты были призваны направлять обсуждения в социальных сетях в выгодную для России сторону, создавая иллюзию массовой поддержки нужных нарративов. План был частью более широкой кампании «Doppelganger» и упоминается в ряде расследований, включая отчет Минюста США (Department of Justice, 2024).

Для иллюстрации можно рассмотреть конкретный пример — публикация с изображением военной техники (БМ-21 «Град»), набравшая 21 тысячу лайков, 1,5 тысячи комментариев и 581 репост. Исходя из коэффициента, эта публикация могла достичь от 210 тысяч до 1 миллиона просмотров, даже без учета дополнительных просмотров через репосты. Такие высокие показатели показывают, как сеть фейковых аккаунтов может эффективно продвигать контент через алгоритмы платформы.

Таким образом, пророссийские публикации, продвигаемые с помощью фейковых аккаунтов, охватывают значительное количество реальных пользователей, формируя их восприятие и оказывая ощутимое влияние на информационное пространство платформы.

Эти страницы и аккаунты публикуют контент преимущественно на английском языке и ориентированы на западную аудиторию, включая пользователей в США. Высокий уровень вовлеченности позволяет этим страницам продвигать свои публикации в лентах новостей у широкого круга пользователей, включая тех, кто не подписан на данные страницы.

В ходе анализа мы выявили десятки подобных публикаций, демонстрирующих российскую военную технику и символику, с тысячами лайков, комментариев и репостов. Это позволяет оценить их охват в сотни тысяч или даже миллионы просмотров. Искусственно созданная активность, поддерживаемая сетью фейковых аккаунтов, способствует широкому распространению этих публикаций через алгоритмы Facebook, усиливая пророссийские нарративы в западном информационном пространстве.

Вот некоторые примеры таких профилей и страниц

50-250 тыс.

просмотров могла бы охватить публикация с 5 тысячами лайков

Vladimir Poutine Z (страница, 120 тысяч подписчиков)

Mandira Roy (страница посвящена исключительно Владимиру Путину, 38 тысяч подписчиков)

Страница MFA-Daily (страница, 23 тысячи подписчиков) на данный момент наполнена рецептами и фото блюд, но это для отвлечения внимания — она “активируется”, как по команде, в нужные периоды времени, и начинает распространять российскую пропаганду или предвыборную агитацию

ATF-5 (страница, 20 тысяч подписчиков). Эта страница в данный момент "маскируется" под страницу, посвященную комиксам, но если пролистать ленту до дат выборов в США, то отчетливо видно, что контент преимущественно пророссийский.

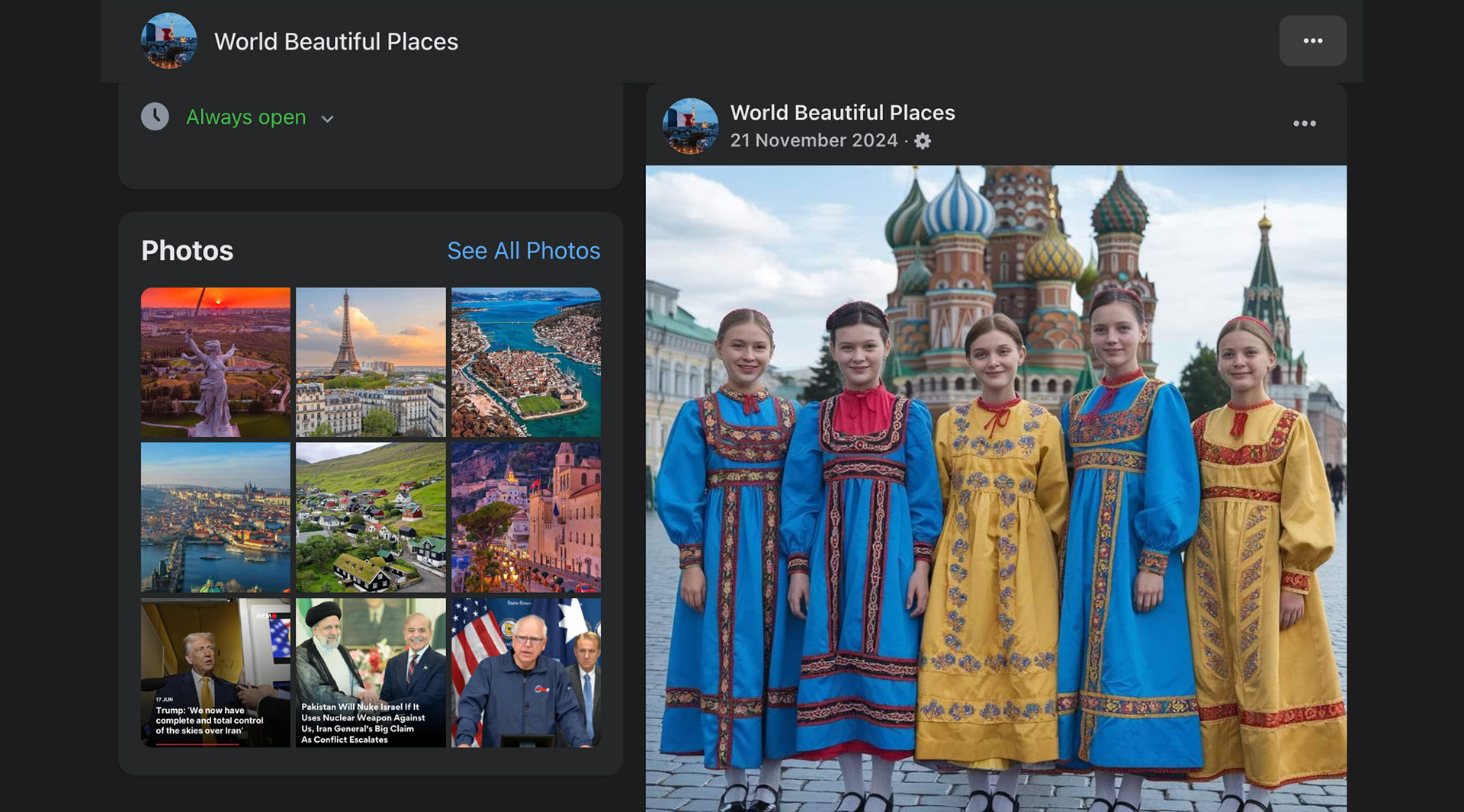

World Beautiful Places (страница, 109 тысяч подписчиков)

Сперва может показаться, что эта страница содержит контент с иллюстрациями достопримечательностей разных стран, но, если пролистать ленту ниже, то видно, что контент преимущественно пророссийский и пропагандистский. Яркий пример — публикация карты Украины с подписью "Russia"

Или образы девушек в военной форме армии СССР

Victoria Paris (страница, 24 тысячи подписчиков)

Маринела Маринельи (профиль, 8 тысяч подписчиков) Профиль создан явно с целью продвижения пропаганды РФ. При этом ряд признаков указывает на то, что профиль фейковый, но Facebook отклонил жалобу и не считает, что имя данного профиля не принадлежит его владельцу.

Десятки и сотни подобных этим страниц и профилей, анализ которых указывает на то, что единственной целью их создания является продвижение пропаганды РФ за рубежом.

Фейковые аккаунты и страницы создаются с целью обойти алгоритмы Facebook и охватить как можно большую аудиторию. Взаимные подписки, лайки и комментарии этих аккаунтов искусственно повышают индекс вовлеченности, что позволяет контенту чаще появляться в лентах новостей пользователей. В результате публикации с милитаристскими изображениями и пророссийскими нарративами получают значительное внимание, включая американских избирателей, что потенциально влияет на их политическое мнение.

Эти аспекты демонстрируют значительный охват и продуманную стратегию российской пропаганды в социальных сетях, направленную на изменение восприятия западной общественности по вопросам поддержки Украины и доверия к демократическим институтам.

Анализ профилей и страниц, участвующих в продвижении пророссийского контента, демонстрирует, что, по меньшей мере, половина комментирующих публикации являются реальными пользователями. Они проявляют обычную активность в социальной сети: обсуждают посты, делятся личным мнением и вовлекаются в дискуссии. Это подтверждает, что алгоритмы Facebook успешно обходятся, даже если на раннем этапе продвижения используются боты или пользователи, выполняющие действия за оплату.

Дальнейший анализ профилей, оставляющих комментарии, показывает, что многие из них принадлежат жителям различных стран, включая США, Великобританию, Германию и другие. Эти пользователи активно участвуют в обсуждениях и делятся контентом со своими подписчиками, усиливая органическое продвижение подобных публикаций.

Таким образом, несмотря на первоначальное использование искусственных методов для увеличения охвата, страницы, продвигающие пророссийские нарративы, находят реальный отклик среди живых пользователей, что делает их влияние ещё более значительным.

Российская пропагандистская кампания в Facebook и других соцсетях, ориентированная на англоязычную аудиторию, имеет косвенные, но важные последствия для европейской политики, особенно в таких странах, как Германия. США, являясь ведущим партнером НАТО и ключевым участником поддержки Украины, оказывает значительное влияние на политический истэблишмент в Германии, Великобритании и других странах. Российские нарративы в США, продвигающие антивоенную риторику и идеи о прекращении поддержки Украины, могут находить отклик и в европейском обществе, особенно через «медиаперекрестки» и международные группы влияния.

Ключевые риски для Германии и ЕС:

Распространение антинатовских и антиукраинских настроений. Пророссийские месседжи, успешно продвигаемые в США, через социальные сети могут просачиваться в политический дискурс Германии и других европейских стран. Это особенно было заметно в преддверии парламентских выборов в Германии, где правые популистские силы, такие как “Альтернатива для Германии” (AfD), активно использовали антивоенные тезисы для мобилизации электората.

Формирование усталости от войны среди европейской аудитории. Пророссийские нарративы, действующие на англоязычных пользователей, могут оказывать вторичное влияние на немецкое общество через транснациональные каналы информации. Поскольку Германия является одним из ведущих доноров военной помощи Украине в Европе, снижение общественной поддержки может привести к давлению на политиков и уменьшению объема помощи.

Политическая дестабилизация через социальные группы и миграционный дискурс. Важно отметить, что Россия активно использует миграционные кризисы для создания напряженности в европейских странах. Это было заметно в ходе предыдущих избирательных циклов в Германии и Австрии, когда дезинформация о беженцах становилась ключевым инструментом мобилизации консервативного и ультраправого электората.

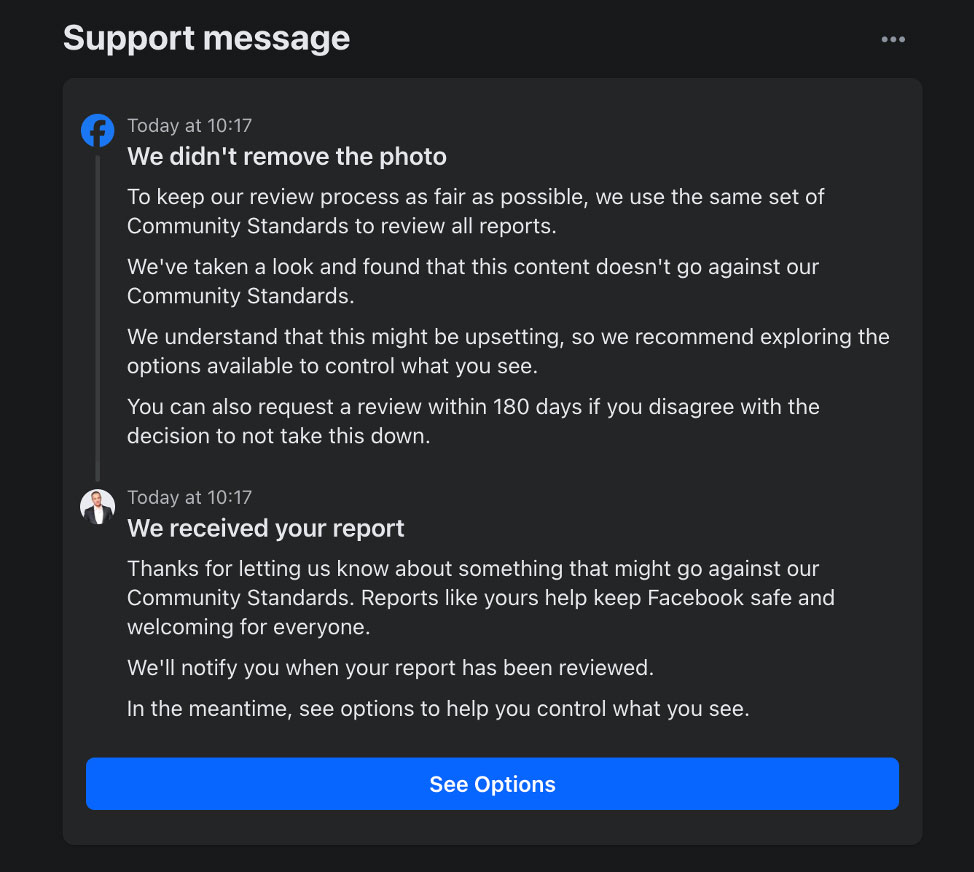

Мы неоднократно пытались пожаловаться на пророссийский контент в Facebook, включающий милитаристские изображения и нарративы, подрывающие поддержку Украины. Несмотря на множество обращений, реакция Facebook оставалась неудовлетворительной. Платформа отклонила без исключения все наши жалобы, указывая на то, что публикации не нарушают стандарты сообщества.

Один из ответов от службы поддержки Facebook гласит: "Мы не удалили фото. Мы проверили и обнаружили, что этот контент не нарушает наши Стандарты сообщества." Сообщение также предлагает пользователям "использовать доступные опции, чтобы контролировать то, что они видят", вместо удаления проблемного контента. Этот пример, как и многие другие, иллюстрирует, что Facebook не рассматривает публикации с символикой "Z" или изображениями российских военных как нарушение, несмотря на их пропагандистский характер.

Поскольку жалобы на подобный контент отклоняются, алгоритмы Facebook продолжают учитывать высокий уровень вовлеченности таких публикаций, что способствует их распространению. Пророссийские страницы и фейковые аккаунты, активно взаимодействующие друг с другом, получают дополнительный органический охват, позволяя этим публикациям попадать в ленты новостей даже у пользователей, которые не подписаны на такие страницы. Это искусственное повышение индекса вовлеченности позволяет пророссийскому контенту достигать широкого круга людей, усиливая влияние пропаганды.

Отсутствие адекватной модерации подобных публикаций, возможно, связано с трудностями в работе с международным контентом и неоднозначностью правил. Так как пророссийские страницы ориентированы на международную аудиторию, алгоритмы модерации не всегда воспринимают их как нарушающие стандарты, особенно если они не используют явные признаки дезинформации. Этот недостаток позволяет пророссийским нарративам беспрепятственно распространяться, несмотря на многочисленные жалобы со стороны исследователей и активистов.

Недостаточная реакция со стороны Facebook делает платформу уязвимой для иностранных информационных операций, подрывающих поддержку Украины и формирующих пророссийские настроения среди западной аудитории. Без адекватного контроля и модерации подобный контент продолжит оказывать значительное влияние на восприятие событий международной политики.

Учитывая значительный охват, российская дезинформационная кампания в социальных сетях оказывает значительное влияние на общественное мнение в США и других странах Запада. Используя визуальные образы, символику и милитаристские нарративы, такие как символ "Z" и фотографии российской военной техники, российская пропаганда формирует положительный имидж российских вооруженных сил и поддерживает политику Кремля. Этот контент распространяется через сотни фейковых аккаунтов и страниц, которые, используя механизмы алгоритмов Facebook, достигают широкой аудитории, включая тех, кто изначально не был подписан на такие страницы.

Согласно отчету Комитета по разведке Сената США, Россия активно использует социальные сети для распространения милитаристской пропаганды, чтобы продемонстрировать свою силу и привлечь внимание западной аудитории. Военные изображения, такие как танки и ракеты, создают привлекательный нарратив для патриотически настроенной аудитории и часто служат для мобилизации пророссийских настроений. Это особенно заметно на фоне текущего конфликта с Украиной, где изображения военной техники и символики могут способствовать формированию антинатовских и антиукраинских взглядов среди западной аудитории.

Другие исследования, такие как анализ Центра стратегических и международных исследований (CSIS), также показывают, что российские информационные операции включают использование ботов и фейковых аккаунтов для создания видимости поддержки России. Например, отчеты CSIS описывают, как с помощью ИИ и автоматизированных аккаунтов распространялись антиукраинские нарративы, создавая иллюзию массовой поддержки этих идей среди американских пользователей.

Глубокое исследование нашего проекта о роли социальных медиа в политической пропаганде также показывает, что социальные сети стали ключевым каналом распространения политической пропаганды, во многом оттеснив традиционные СМИ. Около двух третей населения мира пользуются соцсетями, причем более половины взрослых, например в США, регулярно получают через них новости. Алгоритмы платформ (Facebook, Twitter/X, TikTok, Telegram и др.) способствуют вирусному распространению контента – исследования показывают, что ложные новости распространяются в сетях быстрее, чем правдивые. Такие механизмы, как ленты рекомендаций и группы по интересам, создают «эхо-камеры», в которых пользователи видят преимущественно информацию, подтверждающую их взгляды.

В этих условиях социальные сети стали мощнейшим инструментом влияния на общественное мнение, что активно используется в том числе для государственной пропаганды. Они превратились в наиболее мощное средство воздействия на умы, способствуя распространению как информации, так и дезинформации.

Распространение пророссийских нарративов также способствует "усталости от войны" среди западной аудитории. Постоянное появление в лентах новостей изображений российской армии и позитивных публикаций о России может формировать ложное впечатление о ее правомерности и силе, что снижает уровень поддержки Украины. Это может привести к тому, что западная общественность, особенно в США, начнет воспринимать поддержку Украины как неоправданную, что ослабляет позицию западных демократий в международной арене и способствует снижению финансовой и военной помощи Украине.

Российские дезинформационные кампании также подрывают доверие к западным демократическим институтам, представляя их как неспособные адекватно реагировать на информационные угрозы и защищать своих граждан от внешнего влияния. Согласно исследованию Georgetown Journal of International Affairs (GJIA), путинская пропаганда часто фокусируется на том, чтобы представить западные правительства как неэффективные, а поддержку Украины как ненужную.

Российская пропаганда создает негативное восприятие западных институтов, что может повлиять или, возможно, уже влияет на политические предпочтения американских избирателей и привести к усилению пророссийских настроений внутри США.

Вопрос о том, как регулировать распространение иностранной пропаганды на американских платформах, является сложным из-за необходимости балансировать между защитой свободы слова и национальной безопасностью. В случае российской пропаганды, распространяемой через Facebook, есть вероятность того, что страницы, продвигающие пророссийские нарративы, могут нарушать как законы США, так и ряд требований в области регулирования некоторых бизнес-практик. Например, требования Федеральной торговой комиссии (FTC) и Комиссии по ценным бумагам и биржам США (SEC) о защите пользователей, прозрачности бизнес-практик и предотвращения манипуляций.

Для борьбы с российской пропагандой в Facebook нужен комплексный подход. Используя фейковые аккаунты и страницы, российские информационные кампании успешно обходят алгоритмы платформы, создавая иллюзию широкой поддержки пророссийских нарративов среди западной аудитории.

Необходимость улучшения алгоритмов и модерации контента

Для более эффективного противодействия иностранной пропаганде необходимы прозрачные и усовершенствованные алгоритмы, способные выявлять и ограничивать распространение контента, который искусственно увеличивает вовлеченность через сети фейковых аккаунтов. Facebook, как и другие социальные сети, должны рассмотреть возможность улучшения механизмов модерации, чтобы подобный контент не достигал широкой аудитории. Прозрачные процедуры подачи жалоб и оперативный ответ на них также помогут пользователям чувствовать себя защищенными от дезинформации. К сожалению, попытки добиться от службы модерации Facebook хотя бы какой-то осмысленной реакции раз за разом терпят неудачу.

Вместо этого, автоматические алгоритмы Facebook вводят несправедливые временные ограничения на аккаунты, распространяющие правду о действиях российских вооруженных сил на территории Украины или изображения мемов, сравнивающие Адольфа Гитлера и Владимира Путина (именно это, например, произошло в моем случае — без какой-либо последующей реакции Facebook на поданную апелляцию). Складывается ощущение, что социальная сеть потворствует распространению пропаганды и никак не борется с тысячью фейковых аккаунтов и страниц, созданных с единственной целью — оказать влияние на избирателей в США и странах ЕС.

Комплексное решение проблемы требует совместных усилий американских государственных органов, социальных платформ и гражданского общества. Законодатели и регулирующие органы могли бы рассмотреть дополнительные меры для контроля за деятельностью платформ и их алгоритмами, особенно если это касается распространения российской пропаганды, которая может оказывать влияние на демократические процессы в стране.

В условиях информационной войны и международной агрессии важно не только реагировать на отдельные случаи, но и внедрять долгосрочные стратегии для защиты западной общественности от манипуляции общественным мнением. Прозрачные правила и эффективная модерация помогут такой социальной платформе, как Facebook, оставаться безопасной и заслуживающей доверия средой для пользователей.

Подтверждения и ссылки:

CSIC Report (Center for Strategic and International Studies)

Исследование MOST News & News: “Роль социальных медиа в политической пропаганде: Особенности и влияние российской пропаганды”

SimilarWeb: Подход к оценке коэффициента вовлеченности публикаций в соцсетях

POLITICO.EU: Russian influence operation thrives on Facebook

About.FB.COM: Отчеты Meta о разоблачении крупнейшей сети фейковых аккаунтов, связанных с Россией

Georgetown Journal of International Affairs (GJIA): Влияние российской пропаганды на восприятие конфликта в Украине западной аудиторией.

Источник: GJIA Report

DOJ: Russia Aimed Propaganda at Gamers, Minorities to Swing 2024 Election

AI Forensics: Анализ использования однодневных страниц и таргетированной рекламы для распространения дезинформации

Global Business Outlook: Информация о масштабах политической рекламы в соцсетях и обходе маркировки